Scarica qui la dichiarazione ufficiale dell'avvocatessa di Anthropic

Nel 2025, la giustizia ha avuto più di uno scontro diretto con l’intelligenza artificiale, evidenziandone i rischi per avvocati. In tre casi distinti – Italia, Stati Uniti e Australia – avvocati hanno utilizzato chatbot come ChatGPT e Claude per preparare atti giudiziari. Il risultato? Citazioni giurisprudenziali completamente inventate. Un fenomeno in aumento, che solleva interrogativi urgenti sull’uso dell’intelligenza artificiale giuridica e sull’affidabilità delle sue fonti.

Firenze, gennaio 2025: l’allarme parte dall’Italia

Il primo caso noto in Italia risale all’udienza del 21 gennaio 2025 presso la Sezione imprese del Tribunale di Firenze. Durante una controversia sulla tutela di un marchio e diritti d'autore, il ricorrente ha scoperto che alcune sentenze della Cassazione citate dalla controparte non esistevano.

L’avvocato della parte resistente ha poi ammesso che quelle citazioni erano frutto del lavoro di una collaboratrice che aveva utilizzato ChatGPT. L'avvocato ha dichiarato di non essere stato informato dell’uso dell’IA. Una "svista" che ha suscitato perplessità sia sul piano tecnico che deontologico.

In ogni caso, la Sezione imprese del Tribunale di Firenze ha stabilito che in questo caso l'utilizzo nelle memorie difensive di richiami giurisprudenziali completamente inventati dall’intelligenza artificiale non fa sorgere il diritto della controparte vittoriosa a chiedere la condanna per "responsabilità aggravata" ex articolo 96 del cpc, e cioè per aver "agito o resistito in giudizio con mala fede o colpa grave".

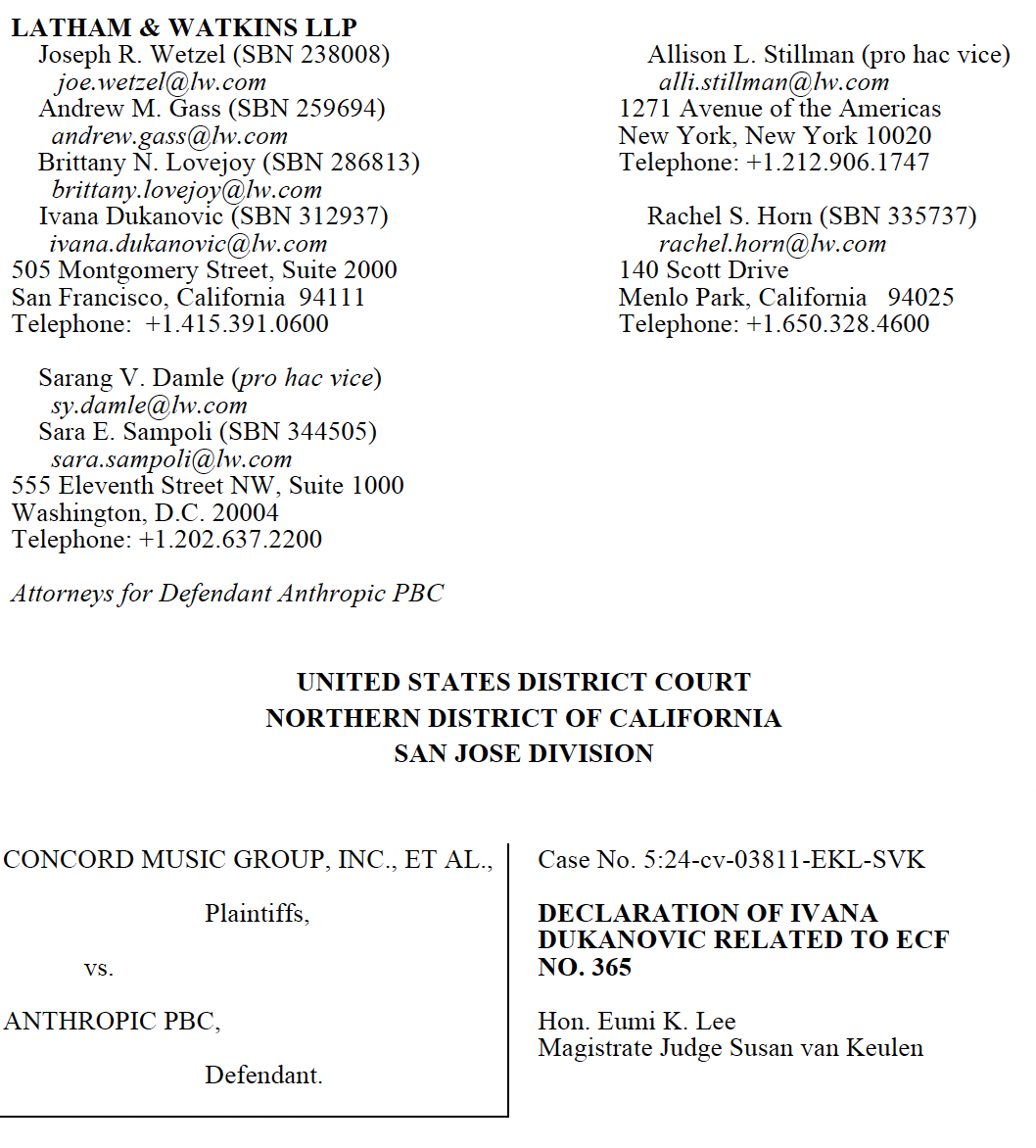

Stati Uniti, maggio 2025: Anthropic stessa diventa vittima del suo chatbot Claude

Il 15 maggio 2025, i legali di Anthropic – la società che ha sviluppato il chatbot Claude – sono stati costretti a scusarsi davanti al Tribunale della California. Nel contesto di una causa sul copyright intentata da Universal Music Group e altri editori, una avvocatessa dello studio legale di cui si affidava Anthropic, aveva utilizzato Claude per formattare le citazioni di alcuni articoli scientifici.

Ivana Dukanovic, l'avvocatessa in questione, avvocato associato del rinomato studio legale Latham & Watkins LLP di San Francisco, dichiara:

Ho chiesto a Claude.ai di fornire una citazione legale correttamente formattata per quella fonte utilizzando il link all’articolo corretto. Sfortunatamente, pur riportando correttamente il titolo della pubblicazione, l’anno di pubblicazione e il link alla fonte fornita, la citazione restituita conteneva un titolo errato e autori incorretti. Il nostro controllo manuale delle citazioni non ha identificato l'errore. Il controllo ha inoltre mancato ulteriori errori di formulazione introdotti durante il processo di formattazione con Claude.ai. [...] Ci scusiamo nuovamente per questi errori di citazione.

Anche in questo caso, l’errore è stato attribuito alle cosiddette "hallucinations" dell’IA: output verosimili, ma privi di fondamento reale.

Scarica qui la dichiarazione ufficiale dell'avvocatessa di Anthropic

Australia, novembre 2024: ChatGPT e la causa d’immigrazione

In una decisione pubblicata il 1° febbraio 2025, il giudice federale australiano Rania Skaros ha deferito un avvocato all’Office of the NSW Legal Services Commissioner (OLSC), l'organo disciplinare degli avvocati australiani.

Il motivo? In una causa d’immigrazione, l'avvocato aveva presentato documenti redatti con ChatGPT contenenti citazioni da decisioni mai esistite.

Riferisce il giudice Skaros:

Entrambi i documenti contenevano citazioni di casi e presunte citazioni di decisioni del tribunale che erano inesistenti.

L'avvocato ha ammesso di aver agito sotto pressione a causa di problemi di salute e scadenze imminenti, affidandosi all’IA senza verificare le fonti. La corte ha definito preoccupante il tempo perso per controllare quei riferimenti inesistenti e ha ammonito sul pericolo di un uso superficiale dell’intelligenza artificiale.

Perché l’intelligenza artificiale non sostituisce l'avvocato

Questi episodi mostrano chiaramente che gli strumenti di IA generativa non sono sostitutivi del rigore professionale degli avvocati. Sono sistemi statistici che predicono la parola più probabile successiva, non strumenti in grado di garantire veridicità. Quando "non sanno", inventano. È il fenomeno noto come "hallucination", citato anche prima. Proprio da qui derivano i rischi connessi all'IA per avvocati.

Per questo è fondamentale:

- Usare IA integrate con banche dati giuridiche, dove ogni fonte è facilmente verificabile.

- Affidarsi a strumenti con tecnologie RAG avanzate (retrieval-augmented generation), che riducono drasticamente le allucinazioni.

- Revisionare sempre il contenuto prodotto e responsabilizzare chi li utilizza, sia professionisti che collaboratori.

Conclusione: conoscere i rischi dell'IA per avvocati può evitare gravi conseguenze

L’intelligenza artificiale giuridica è uno strumento straordinario, ma non può sostituire il rigore, la verifica e l’etica professionale dell’avvocato. I tre casi analizzati non sono semplici curiosità tecnologiche: rappresentano segnali d’allarme. E ignorarli può costare caro, in termini legali e reputazionali.